Crawl Budget

Inhaltsverzeichnis

- 1 Wie wird das Crawl Budget einer Webseite ermittelt?

- 2 Warum wird das Crawling limitiert?

- 3 Faktoren, die sich negativ auf das Crawl Budget auswirken

- 4 Warum ist ein hohes Crawl Budget wichtig?

- 5 Crawl Budget: vor allem für größere Webseiten relevant

- 6 Ausschöpfung des Crawl Budgets – konkrete Schritte zur Optimierung

- 7 Weblinks

Der Googlebot crawlt fortlaufend eine sehr große Zahl an Webseiten. Bei großen Domains wird dabei nicht immer der gesamte Inhalt berücksichtigt, sondern nur eine gewisse Anzahl der vorhandenen Seiten. Beim Crawl Budget einer Website handelt es sich um die maximale Anzahl an Unterseiten, die vom Googlebot auf einer Webseite gecrawlt werden. Google ermittelt für jede Domain ein eigenes, individuelles Crawl Budget.

Wie wird das Crawl Budget einer Webseite ermittelt?

Google spricht bei der Definition des Crawl Budgets von der maximalen Anzahl Seiten, die der Googlebot crawlen „kann und will“. Folgendes hat es mit dieser Aussage auf sich:

Crawling-Frequenz:

Diese Größe besagt, wie häufig der Googlebot eine Webseite crawlt.

Je schneller der Server reagiert und je besser Daten abgreifbar sind, desto effizienter können Inhalte gecrawlt werden – die Crawling-Frequenz steigt. Für ein effizientes Crawling sind ein schneller Server und zügig landende Webseiten von Vorteil. Der Crawling-Fehlerbericht für Websites in der Google Search Console gibt Aufschluss darüber, bei welchen URLs Fehler beim Crawling auftauchen. So können Bereiche identifiziert werden, die der Bot gar nicht crawlen kann.

Crawling-Bedarf:

Je populärer und frischer die Inhalte einer Webseite, desto häufiger wird diese gecrawlt. Bei Seiten mit einer hohen Anzahl an Backlinks, aktuellen und gefragten Inhalten nimmt Google einen höheren Crawling-Bedarf an und berücksichtigt sie stärker. Fällt der Crawling-Bedarf gering aus, wird das potenzielle Crawl Budget nicht komplett ausgeschöpft: Der Googlebot reduziert seine Crawling-Aktivitäten, sobald kein Bedarf mehr für das Indexieren neuer oder die Aktualisierung vorhandener Webseiten besteht.

Warum wird das Crawling limitiert?

Der Googlebot crawlt Seiten nicht zu oft und zu schnell, da es eine Belastung für den Server darstellt und z. B. dazu führen könnte, dass sich Ladezeiten verlängern und das Erlebnis der Seitenbesucher (User Experience) durch das Crawling beeinträchtigt wird.

Es besteht die Möglichkeit, die Crawl-Rate über die Google Search Console zu steuern. Während eine Erhöhung der Frequenz laut Google nicht automatisch dazu führt, dass die Webseite öfter gecrawlt wird, kann eine Reduzierung beispielsweise dann sinnvoll sein, wenn Serverkapazitäten geschont werden sollen.

Faktoren, die sich negativ auf das Crawl Budget auswirken

- URLs, die keine relevanten Inhalte besitzen (Facettierte Navigation und Session-IDs)

- Soft Errors

- Duplicate Content

- Inhalte mit geringem Mehrwert und Spam

- Gehackte Seiten

Warum ist ein hohes Crawl Budget wichtig?

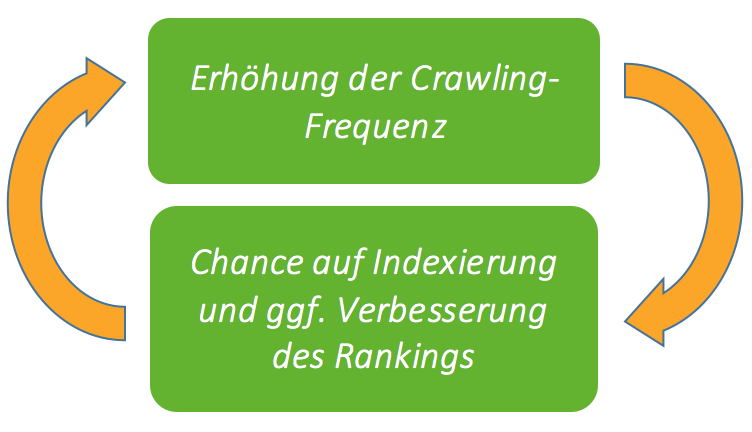

Das Crawl Budget spielt eine bedeutende Rolle für die Indexierung großer Webseiten. Je größer das Crawl Budget der Domain, desto mehr Seiten können gecrawlt werden, im Index erscheinen und in den Suchergebnissen (SERPs) auftauchen. Seiten mit hochwertigen, aktuellen Inhalten haben (durch die Erhöhung des Crawling-Bedarfs) einen positiven Einfluss auf das Crawl Budget und profitieren umgekehrt von seiner Erhöhung, da der Googlebot häufiger überprüft, ob sie zu Suchanfragen passen und ihre Relevanz neu bewertet. So können sie in den SERPs schneller aufsteigen.

Google betont allerdings: Das Crawl Budget steht nicht in direktem Zusammenhang mit dem Ranking-Faktor. Eine Webseite, die häufiger gecrawlt wird, erscheint nicht automatisch in den Suchergebnissen weiter oben. Das Ranking kann sich indirekt dadurch erhöhen, dass die Anzahl an gecrawlten und indexierten Seiten einer Domain wächst.

Crawl Budget: vor allem für größere Webseiten relevant

Das Crawl Budget ist ein Faktor, mit dem sich die Betreiber kleinerer Webseiten meist weniger auseinandersetzen müssen. Die Grenze, bei der das Crawl Budget möglicherweise ausgeschöpft wird, liegt laut Google bei über tausend Unterseiten.

Bei umfangreichen Webseiten mit vielen Unterseiten stellt das Crawl Budget durchaus eine relevante Größe dar. Es sollte sichergestellt werden, dass der Googlebot effizient crawlen kann (Optimierung der Reaktionszeiten) und dabei auch genau die Seiten berücksichtigt, die für die eigenen Zwecke von besonderer Relevanz sind (Priorisierung der Unterseiten in der XML-Sitemap).

Ausschöpfung des Crawl Budgets – konkrete Schritte zur Optimierung

Wie der Googlebot das Crawl Budget einer Webseite ausnutzt, also welche Seiten gecrawlt werden, hängt von mehreren Faktoren ab. Eine wichtige Rolle spielen hier die interne Linkstruktur und die enthaltenen Backlinks einer Seite.

Besonders für große Webseiten ist es wichtig, dass das Crawl Budget möglichst sinnvoll genutzt wird. Um die Chance zu erhöhen, dass relevante Unterseiten indexiert werden, können Webmaster durch gezielte Maßnahmen versuchen, den Googlebot so zu steuern, dass er diese bevorzugt crawlt.

- Duplicate Content, wenn möglich, entfernen

- Geeignete Tools helfen bei der Identifizierung der entsprechenden URLs

- Webseiten von hoher Qualität stärken, damit sie gecrawlt werden

- Optimierung der internen und externen Verlinkung

- Hierarchisierung der Unterseiten in einer XML-Sitemap

- Flache interne Seitenarchitektur (schnelle Erreichbarkeit von Hauptseite aus)

- Duplicate Content, wenn möglich, entfernen

- Geeignete Tools helfen bei der Identifizierung der entsprechenden URLs

- Sicherstellen, dass der Googlebot alle relevanten Bereiche crawlen kann

- Die robots.txt-Datei ist regelmäßig zu prüfen und die XML-Sitemap aktuell zu halten. Serverfehler können z. B. mithilfe der Google Search Console ermittelt werden.

Gezielter Ausschluss einzelner Inhalte vom Crawling

Der Googlebot folgt bevorzugt URLs, die in der Sitemap aufgeführt sind. Webmaster sollten grundsätzlich Seiten aus der XML-Sitemap entfernen, die keine relevanten Inhalte besitzen, um das Crawl Budget zu schonen.

Eine Seite lässt sich mithilfe des Meta-Tags noindex von der Indexierung ausschließen.

<meta name=“robots“ content=“noindex, follow“ />

Die Webseite soll nicht indexiert werden, der Googlebot soll aber den dort vorhandenen Links folgen.

Sicherstellen, dass eine Seite nicht in den Index kommt, kann man mit dieser Methode letztlich nicht. Sobald Links auf die Seite verweisen, wird der Googlebot sie in den Index aufnehmen – aber nicht crawlen.

Um bestimmte Dateien einer Webseite gezielt vom Crawling auszuschließen, können entsprechende Einträge in der robots.txt vorgenommen werden:

Disallow: /Ordnername/

Disallow: /Dateiname/

Sollen die Crawler aller Suchmaschinen ausgeschlossen werden, wird bei User-Agent ein Stern als Platzhalter gesetzt: *

Möglich ist eine solche Sperrung von Inhalten für das Crawling z. B. für Bilder, Dateien eines bestimmten Formats, Verzeichnisse oder Teilverzeichnisse.

Weblinks

Googles Handbuch für Websiteinhaber zur Verwaltung des Crawling-Budgets

Google über die Bedeutung des Crawl Budgets

Weiterführende Informationen